Vi spieghiamo in questo articolo cos’è successo nei quartieri generali di Meta e perché i profili di influencer con immagini generati dall’intelligenza artificiale potrebbero essere a rischio.

Meta ha annunciato una revisione della sua politica relativa ai contenuti generati dall’intelligenza artificiale (AI) su Facebook, Instagram e Threads. Questo aggiornamento mira più alla trasparenza che alla rimozione dei contenuti.

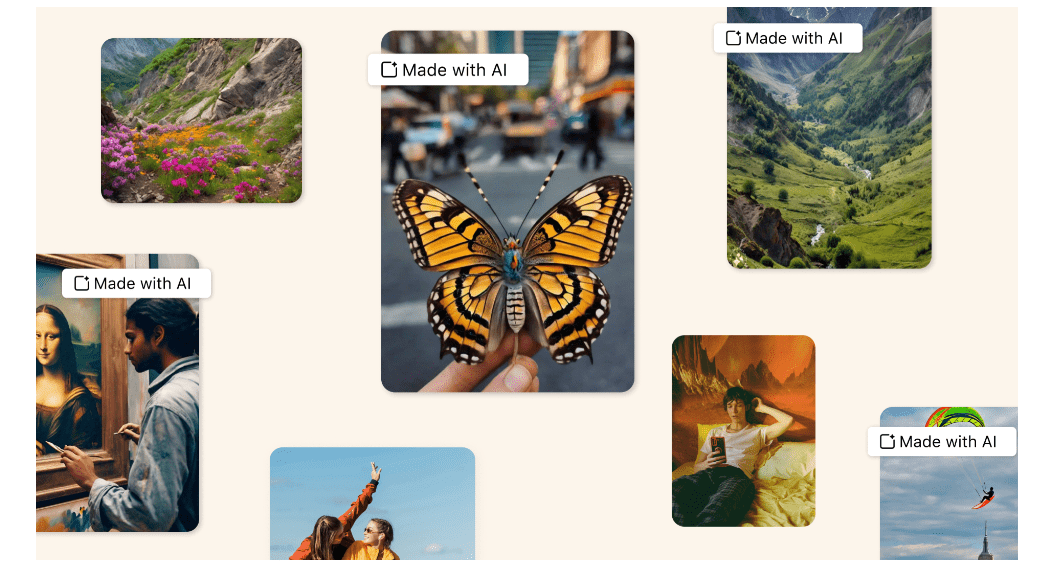

La novità principale riguarda l’estensione della definizione di “media manipolati”, che ora include non solo i video generati dall’AI, ma anche audio e immagini ingannevoli. Questa mossa dimostra una maggiore sensibilità verso la libertà di espressione: invece di rimuovere i contenuti problematici, Meta ha scelto di etichettarli. Le nuove etichette, “Made with AI” and “Imagined with AI,”, chiariscono quali contenuti sono stati creati o modificati tramite AI. I contenuti verranno etichettati in questo modo a partire da maggio 2024.

Quindi, per i contenuti generati dall’AI, saranno usate due etichette basate sulla rilevazione di segnali condivisi dall’industria o sull’autodichiarazione degli utenti che caricano contenuti generati dall’AI. I contenuti particolarmente ingannevoli potrebbero ricevere etichette più evidenti, per aiutare gli utenti a comprendere meglio di cosa si tratta. Tuttavia, i contenuti dannosi che violano gli Standard della Comunità, come quelli che incitano alla violenza o all’interferenza elettorale, saranno rimossi, indipendentemente dalla loro origine umana o AI.

La politica originale sull’etichettatura dell’AI risale al 2020 e, a causa dello stato della tecnologia di allora, era limitata principalmente ai video ingannevoli. Con l’evoluzione della tecnologia, il Consiglio di Sorveglianza di Meta ha riconosciuto la necessità di un aggiornamento che ora include anche audio e immagini generati dall’AI.

La revisione della politica si basa su un ampio feedback raccolto da un vasto spettro di stakeholder e dal pubblico. Meta ha consultato oltre 120 stakeholder in 34 paesi e condotto ricerche di opinione pubblica con più di 23.000 rispondenti in 13 paesi, scoprendo un forte supporto per l’etichettatura dei contenuti generati dall’AI, soprattutto in scenari ad alto rischio.

Meta intende aggiornare periodicamente le sue politiche in collaborazione con organizzazioni come la Partnership on AI, governi e ONG, per tenere il passo con i rapidi avanzamenti tecnologici. La politica rivista pone un forte accento sulla trasparenza e il contesto dei contenuti generati dall’AI, preferendo l’etichettatura alla rimozione dei contenuti problematici.

Questa strategia riflette un equilibrio tra il promuovere la libertà di espressione e la necessità di combattere la disinformazione, mostrando un chiaro impegno di Meta verso una maggiore responsabilità nel trattamento dei contenuti generati dall’intelligenza artificiale.

Perché potrebbe essere rischioso per gli influencer creati con l’intelligenza artificiale?

L’aggiornamento della politica di Meta sui contenuti generati dall’intelligenza artificiale (AI) su piattaforme di social media marketing come Instagram rappresenta un cambio significativo che influisce direttamente sugli influencer creati con l’AI. Questa situazione porta con sé diverse implicazioni e potenziali rischi che meritano un’analisi approfondita.

- Impatto sulla credibilità e autenticità. Gli influencer virtuali, creati e gestiti attraverso l’intelligenza artificiale, potrebbero affrontare sfide legate alla percezione della loro autenticità. L’etichettatura dei contenuti come “Creato con AI” potrebbe influenzare la percezione degli utenti riguardo la genuinità degli influencer AI. In un’era in cui l’autenticità è molto valorizzata, questo potrebbe diminuire l’engagement e la fiducia dei follower.

- Percezione pubblica e accettazione. L’uso di etichette specifiche potrebbe anche alterare la percezione pubblica di questi influencer, categorizzandoli come entità meno credibili o serie rispetto ai loro omologhi umani. Questo potrebbe avere ripercussioni sulla loro capacità di influenzare efficacemente o di essere visti come affidabili da parte delle aziende per partnership e collaborazioni.

- Transparenza vs. intrusività. Sebbene la trasparenza sia fondamentale, esiste un delicato equilibrio tra fornire informazioni chiare sull’origine dei contenuti e mantenere una certa magia o mistero intorno alla creazione degli influencer AI. L’eccessiva enfasi sulla loro natura AI potrebbe ridurre l’effetto “wow” che contribuisce al loro fascino.

- Impatto sulle partnership e monetizzazione. Le aziende potrebbero essere più caute nel collaborare con influencer AI etichettati in modo chiaro, temendo che l’affiliazione possa influenzare negativamente la percezione del loro marchio. Questo può complicare gli sforzi di monetizzazione degli influencer AI, riducendo le opportunità di partnership e influenzando il loro potenziale di guadagno.